Nginx 配置实例—负载均衡

本文最后更新于:2 年前

实现效果

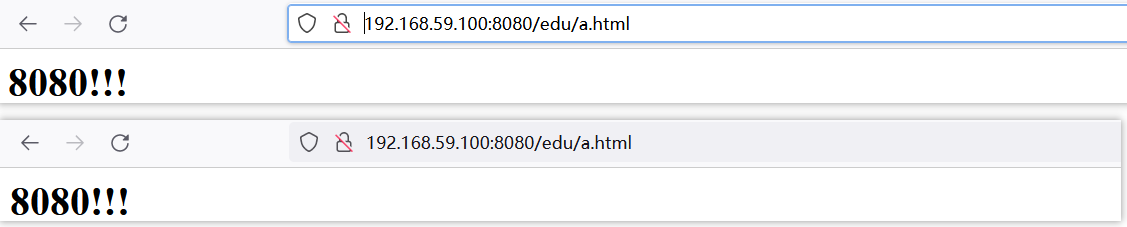

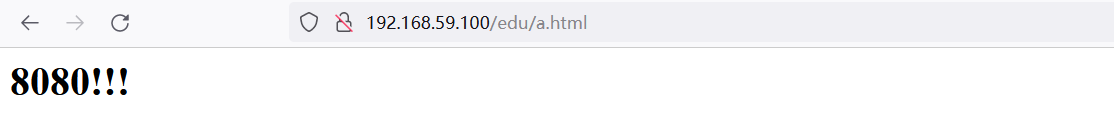

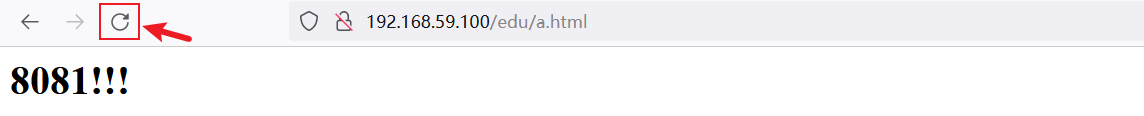

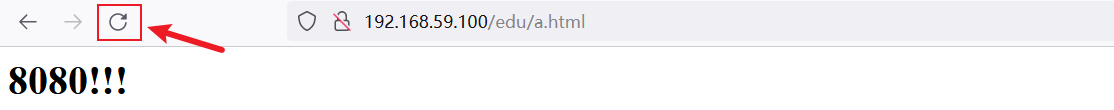

浏览器地址栏输入地址 http://192.168.59.100/edu/a.html,负载均衡效果,平均到 8080和 8081 端口中。

准备工作

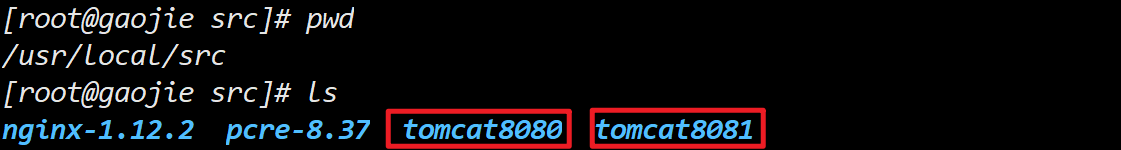

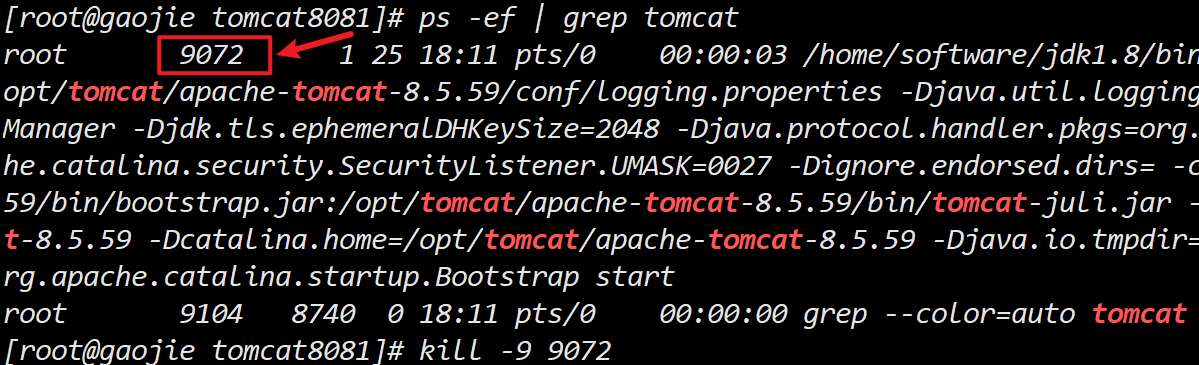

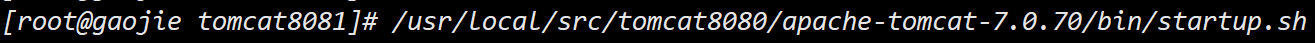

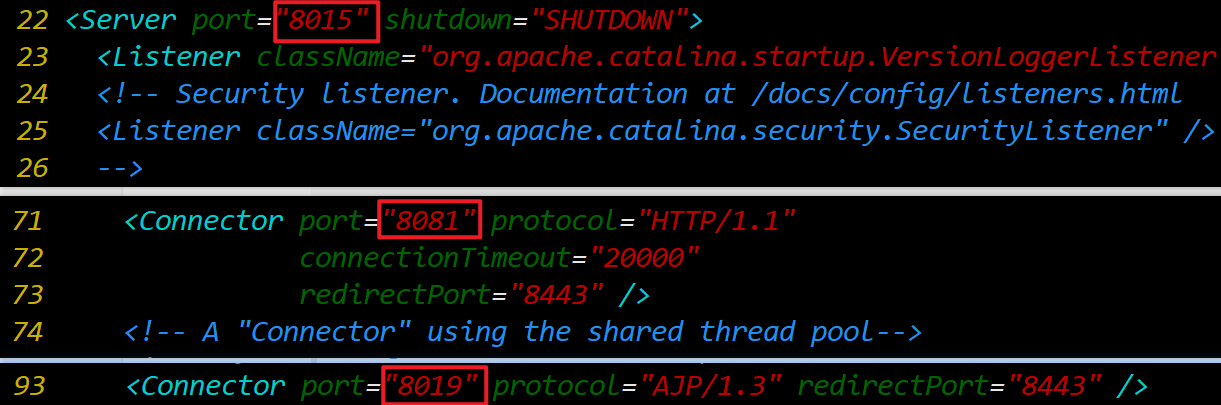

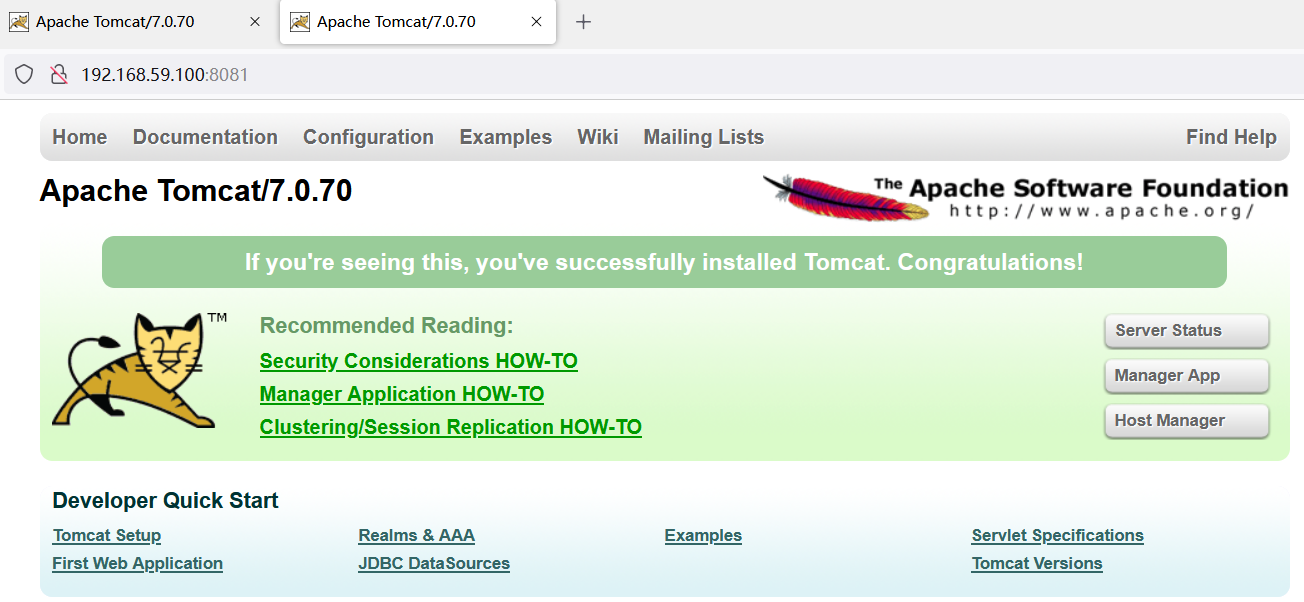

准备两台 tomcat 服务器,一台 8080,一台 8081

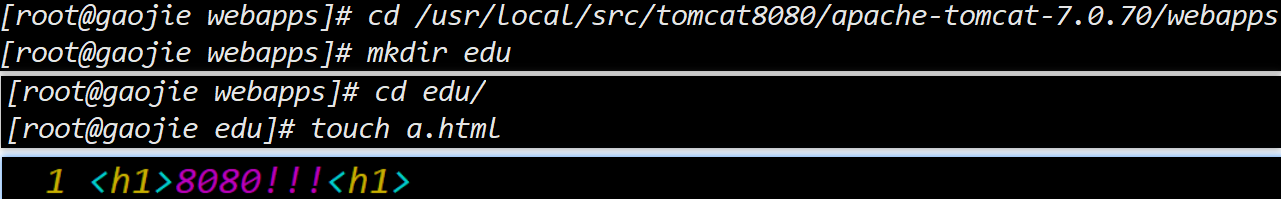

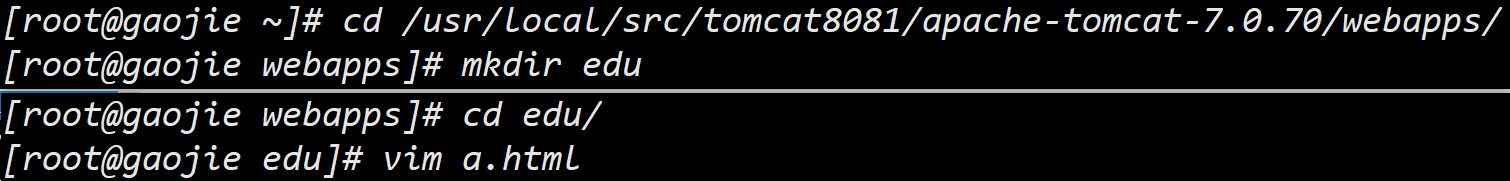

创建文件夹和测试页面

在两台 tomcat 里面 webapps 目录中,创建名称是 edu 文件夹,在 edu 文件夹中创建页面 a.html,用于测试。

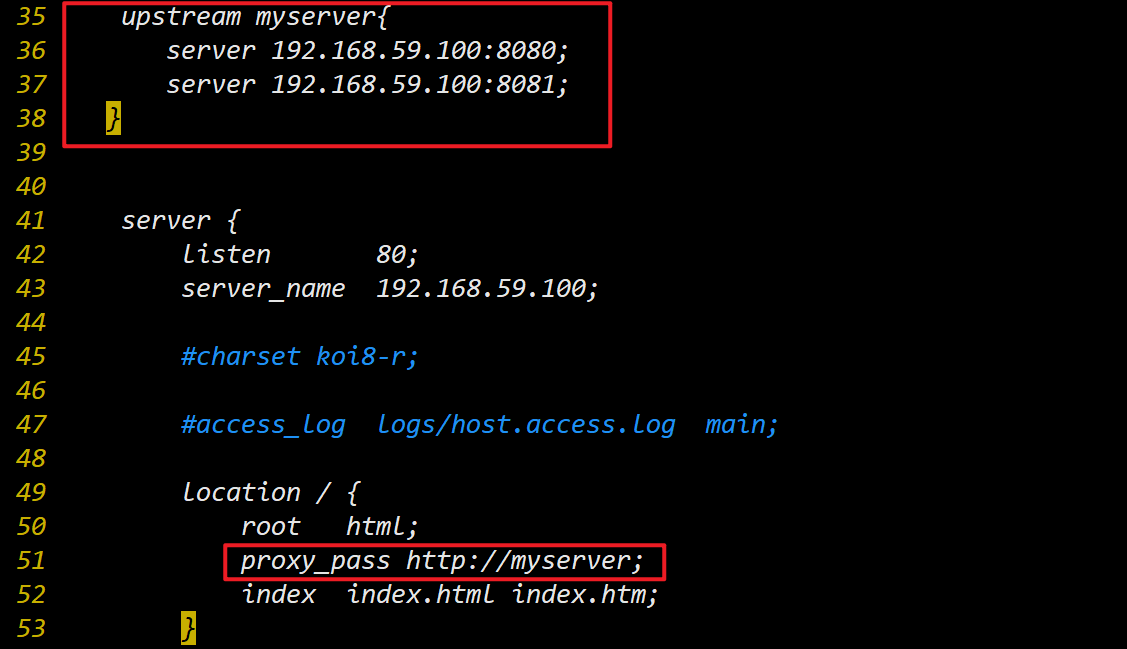

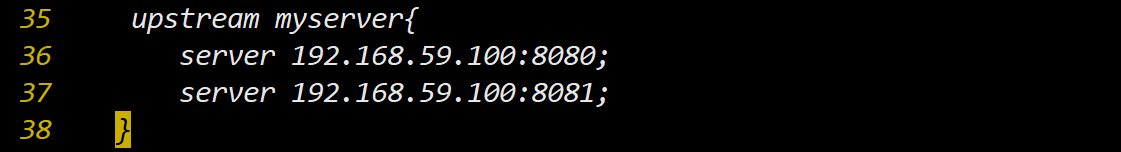

具体配置

在 nginx 的配置文件中进行负载均衡的配置

1 | |

最终效果

重启 Nginx 服务器

1

[root@gaojie edu]# /usr/local/nginx/sbin/nginx -s reload访问测试页面

可以看出,请求被负担到不同服务器当中,实现了负载均衡。

nginx 分配服务器策略

轮询(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器 down 掉,能自动剔除。

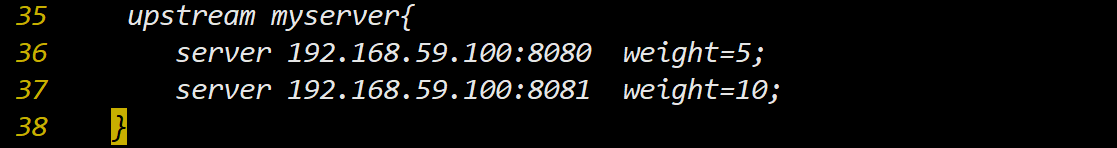

weight

weight 代表权,重默认为 1,权重越高被分配的客户端越多。用于后端服务器性能不均的情况。

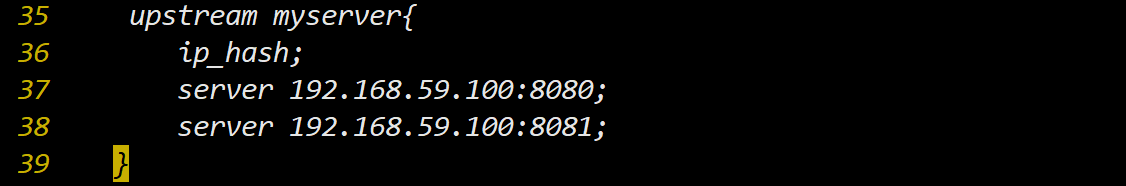

ip_hash

每个请求按访问 ip 的 hash 结果分配,这样每个 ip (客户端)固定访问一个后端服务器,可以解决 session 的问题。

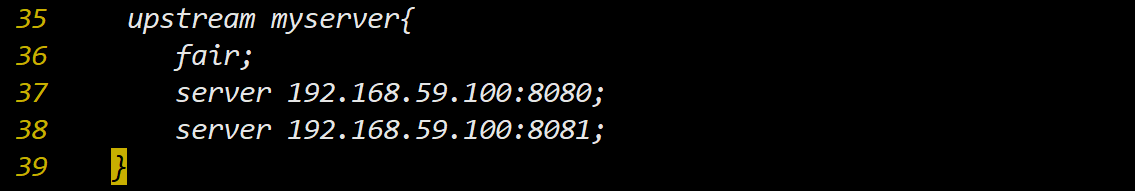

fair(第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!